Crawl là gì? Bất kỳ một SEOer nào cũng cần biết và tìm hiểu sâu về crawl, bởi nó quyết định website của bạn có xuất hiện khi người dùng tìm kiếm hay không. Vậy các kiến thức nào về crawl mà chúng ta cần biết? Hãy theo dõi bài viết dưới đây của dichvupbn – địa chỉ bạn có thể mua backlink pbn chất lượng – để được thêm thông tin bổ ích hơn nhé!

Giới thiệu crawl trong SEO

Crawl là gì?

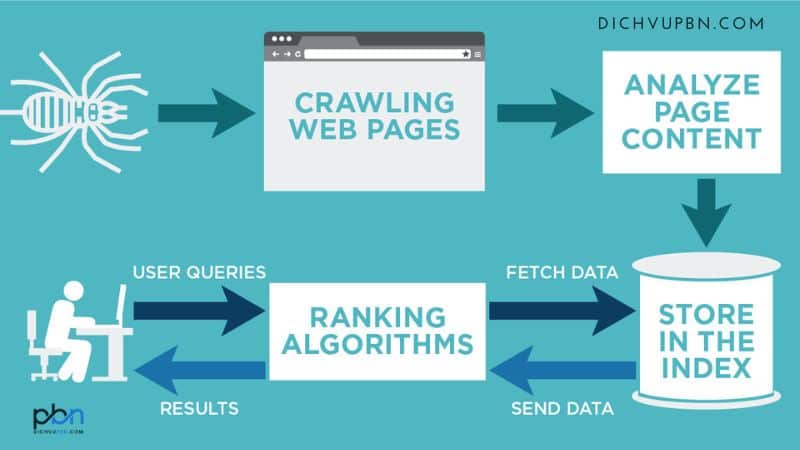

Crawl là gì? (hay crawl data là gì?) – Đây là thuật ngữ kỹ thuật khi các con bot từ công cụ tìm kiếm sẽ hoạt động thu thập dữ liệu từ trang bất kỳ. Sau khi thu thập, con bot sẽ tiến hành phân tích mã nguồn HTML, đọc và lọc dữ liệu của website đó.

Crawling là gì

Crawling là gì?

Trong SEO website, crawling là quá trình thu thập dữ liệu, trong đó các bot từ công cụ tìm kiếm (như Googlebot) sẽ khám phá nội dung trên một trang web theo hệ thống. Những gì “con bot” thu thập có thể là văn bản, video hay các loại tệp khác, miễn là con bot truy cập được. Bất kể định dạng nào, nội dung mà con bot thu thập chỉ được tìm thấy thông qua các liên kết.

Vì sao hiểu được quy trình crawl lại quan trọng với SEO

Crawl (thu thập dữ liệu) rất quan trọng đối với SEO bởi nó cho phép các công cụ tìm kiếm có thể hiểu nội dung trên trang web của bạn. Khi công cụ tìm kiếm đã hiểu nội dung rồi, nó sẽ xếp hạng website của bạn theo mức độ liên quan và chất lượng web.

Nếu trang web không được thu thập dữ liệu, thì nó sẽ không thể xuất hiện trong mọi kết quả tìm kiếm (SERP). Nghĩa là bạn sẽ phải bỏ lỡ lưu lượng truy cập không cần trả tiền nhưng có giá trị từ người dùng đang tìm kiếm thông tin. Và ngay cả khi trang web được thu thập dữ liệu sau đó, trang web cũng không được lập chỉ mục đúng cách. Dẫn đến thứ hạng trang web đó thấp và khả năng hiển thị bị kém đi.

Cách hoạt động của quá trình crawling trên website

Về cơ bản, trình thu thập dữ liệu web (con bot) hoạt động bằng cách khám phá các URL và tải xuống nội dung của trang đó. Trong quá trình này, các con bot có thể “di chuyển” nội dung sang chỉ mục của công cụ tìm kiếm và trích xuất các liên kết đến trang web khác.

Quy trình crawling

Các liên kết được con bot tìm thấy sẽ thuộc các phân loại khác nhau, bao gồm:

- URL mới: là URL mà công cụ tìm kiếm chưa phát hiện trước đó.

- Các URL đã biết nhưng không có hướng dẫn về thu thập thông tin: các URL này được xem lại theo “định kỳ” để kiểm tra có bất kỳ thay đổi nào về nội dung của trang đó không. Qua đó mà chỉ mục của công cụ tìm kiếm sẽ cần được cập nhật mới.

- Các URL đã biết và đã được cập nhật: các URL này được thu thập lại dữ liệu và lập lại chỉ mục. Chẳng hạn như thông qua lịch sử sửa đổi lần cuối của sơ đồ trang web XML.

- Các URL đã biết và chưa được cập nhật: các URL này không cần thu thập hay lập chỉ mục lại.

- Các URL không thể truy cập: dạng URL này không thể hoặc không nên được theo dõi. Chẳng hạn như các URL sau biểu mẫu đăng nhập hay các liên kết bị chặn.

- Các URL không được phép: là bot công cụ tìm kiếm sẽ không thu thập dữ liệu, chẳng hạn như các URL bị chặn bởi tệp robots.txt.

Hầu hết các công cụ tìm kiếm đều có bot riêng, như Googlebot, Yahoo Slurp, Yandex bot… Mỗi bot sử dụng các thuật toán cụ thể để xác định dữ liệu. Nghĩa là không phải thông tin thu thập được từ bot nào cũng như nhau.

Một số “rắc rối” khi thu thập dữ liệu

Có bao giờ bạn tự hỏi các rắc rối mà nhiều SEOer gặp phải khi crawl là gì chưa? Một số vấn đề phổ biến từ website có thể ảnh hưởng đến việc thu thập dữ liệu và lập chỉ mục, chẳng hạn như:

- Nội dung bị trùng lặp: có nhiều trang có cùng một nội dung, chúng khiến các con bot của công cụ tìm kiếm bị nhầm lẫn, dẫn đến thứ hạng của website bạn bị đánh giá thấp.

- Liên kết bị hỏng: việc các liên kết bị hỏng có thể ảnh hưởng đến trình thu thập thông tin truy cập của các trang quan trọng trên website.

- Tệp robot.txt: tệp robot.txt là tệp văn bản cho trình thu thập thông tin từ công cụ tìm kiếm biết những trang hay phần nào trên website không được lập chỉ mục. Nếu nó không được cấu hình đúng thì tệp này vẫn có thể chặn thu thập dữ liệu ở các trang quan trọng.

- Chuyển hướng: phần chuyển hướng rất hữu ích bởi nó di chuyển người dùng từ trang cũ sang trang mới. Nhưng nếu việc này không được thực hiện đúng cách thì chúng có thể gây nhầm lẫn cho chu trình crawl và ảnh hưởng đến việc lập chỉ mục.

Hướng dẫn tối hỗ trợ quá trình BOT crawl dữ liệu tốt hơn

Nếu bạn đang muốn tối ưu hóa việc Crawl là gì, hãy thử các phương pháp như:

tói ưu quy trình crawl

- Tạo sơ đồ trang web XML: sơ đồ này là một tệp chứa danh sách mọi trang trên website của bạn. Nó giúp trình thu thập thông tin khám phá và lập chỉ mục cho nội dung dễ dàng hơn.

- Dùng URL mô tả: sử dụng URL mô tả và có giàu từ khóa phản ánh nội dung của trang một cách chính xác nhất. Có thể bạn cần phải biết về các yếu tố liên quan đến url như canonical url….

- Sửa chữa các liên kết bị hỏng: SEOer hãy thường xuyên kiểm tra trang web của mình để tìm các liên kết bị hỏng và khắc phục chúng kịp thời.

- Sử dụng chuyển hướng đúng cách: hãy thử sử dụng chuyển hướng 301 để chuyển hướng người dùng và trình thu thập thông tin từ trang cũ sang trang mới.

- Tránh các nội dung mang tính trùng lặp: khi xây dựng nội dung, hãy đảm bảo trang web của bạn có nội dung độc đáo nhất, việc trùng lặp với trang khác có thể khiến con bot công cụ tìm kiếm đánh giá thấp trang của bạn.

- Sử dụng robots.txt thật cẩn thận: tệp robots.txt được dùng để chặn các trang không được lập chỉ mục. Tuy nhiên, tệp này nếu không dùng cẩn thận có thể vô tình chặn các trang quan trọng của website.

Các công cụ hỗ trợ cho việc thu thập dữ liệu (Crawl)

Có một giả thuyết cho rằng, thay vì trình thu thập dữ liệu của công cụ tìm kiếm quyết định nội dung thu thập dữ liệu, các trang web có thể đẩy trực tiếp URL liên quan đến cho công cụ tìm kiếm. Quá trình này dựa vào API để kích hoạt crawling.

Công cụ hỗ trợ crawl là gì

Về mặt lý thuyết, việc này cho phép bạn lập chỉ mục nội dung mới nhất của mình nhanh hơn. Đồng thời, bạn cũng có thêm cách xóa các URL cũ hiệu quả hơn. Hãy thử sử dụng các công cụ hỗ trợ như:

Hỗ trợ từ IndexNow

API đầu tiên bạn nên thử là IndexNow, nó được hỗ trợ bởi Bing, Seznam và Yandex (không có Google). IndexNow được tích hợp vào nhiều công cụ SEO, CRM và CDN nên việc sử dụng rất tiện lợi.

Tuy nhiên, hãy kiểm tra xem đối tượng khách hàng mục tiêu của bạn có sử dụng các công cụ tìm kiếm được IndexNow hỗ trợ không? (đã được đề cập ở trên). Nếu không, việc kích hoạt crawling từ bot cho trang web có thể bị hạn chế.

Bên cạnh đó, bạn cũng cần đánh giá việc tích hợp trên IndexNow có ảnh hưởng như thế nào đến máy chủ so với việc cải thiện điểm thu thập thông tin từ công cụ tìm kiếm đó. Đôi khi, chi phí bạn phải bỏ ra không tương xứng với những gì bạn nhận được.

Hỗ trợ Google Indexing API

Đối với Google Indexing API, bạn có thể nhận thấy việc thu thập dữ liệu tăng đáng kể (đã có nhiều người thử và thành công). Bằng cách hãy gửi các URL không tuân thủ tới API lập chỉ mục của Google.

Đối với các URL này, việc gửi thông tin không ảnh hưởng đến việc lập chỉ mục. Google sẽ thu thập dữ liệu trang nhanh chóng để xem liệu nó có dữ liệu có cấu trúc được chỉ định không. Nhờ đó mà việc crawling lẫn lập chỉ mục được đẩy nhanh.

Hỗ trợ từ công cụ Google Search Console

Có một cách mà Google hỗ trợ thu thập dữ liệu, đó là bạn gửi theo cách thủ công trong Google Search Console. Hầu hết các URL được gửi theo cách này sẽ được thu thập dữ liệu và thay đổi trạng thái lập chỉ mục của chúng trong vòng chỉ 1 giờ.

Tuy nhiên, giới hạn là bạn chỉ được gửi 10 URL trong 24 giờ. Bạn có thể gửi tự động các URL ưu tiên thông qua tập lệnh bắt chước hành động người dùng. Cách này giúp tăng tốc độ thu thập dữ liệu và lập chỉ mục cho các URL được chọn.

Tóm lại, hiểu về quá trình crawling vô cùng cần thiết để giúp bạn có thể hỗ trợ các công cụ tìm kiếm hiểu nội dung của trang web bạn và lập chỉ mục phù hợp. Hy vọng các thông tin trên đây về crawl là gì có thể giúp bạn hiểu rõ hơn về vấn đề này. Đồng thời, bạn sẽ có thêm phương pháp cải thiện thứ hạng cho website của mình.